FORTALECIMIENTO DEL INSTITUTO ANDALUZ DE MATEMÁTICAS (IAMAT)

Las infraestructuras de cálculo científico del IAMAT han sido renovadas con una ayuda del PAIDI y otra del Plan Nacional de I+D+i.

El PAIDI ha concedido una ayuda al FORTALECIMIENTO DEL INSTITUTO ANDALUZ DE MATEMÁTICAS (IAMAT) (SOMM17/6111/USE). La ayuda forma parte de los incentivos a los agentes del sistema andaluz del conocimiento ayudas a la i+d+i, en el ámbito del plan andaluz de investigación, desarrollo e innovación (paidi 2020).

La ayuda viene recogida en una resolución de la secretaría general de universidades, investigación y tecnología por la que se conceden subvenciones en relación a la convocatoria 2017 de ayudas para el programa de fortalecimiento de institutos universitarios de investigación de las universidades andaluzas, centros e infraestructuras para la adquisición del sello «Severo Ochoa» o «María de Maeztu».

Por otra parte, el Plan Nacional de I+D+i ha concedido una ayuda al Instituto de Matemáticas de la Universidad de Sevilla (IMUS), dentro del programa de ADQUISICIÓN DE EQUIPAMIENTO CIENTÍFICO-TÉCNICO CORRESPONDIENTES AL SUBPROGRAMA ESTATAL DE INFRAESTRUCTURAS DE INVESTIGACIÓN Y EQUIPAMIENTO CIENTÍFICO-TÉCNICO (EQC2018-004324-P).

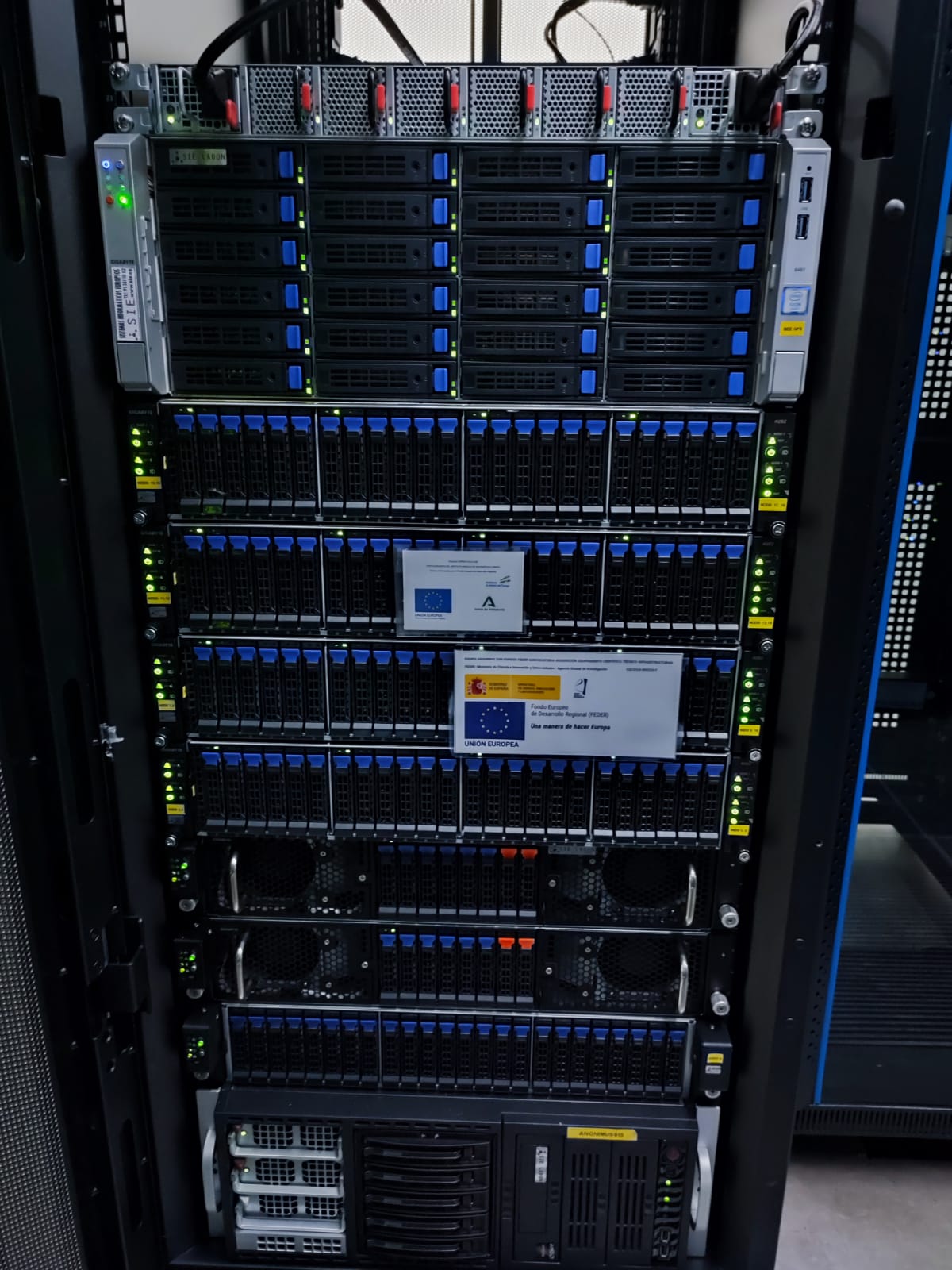

Las infraestructuras en supercomputación adquiridas con los fondos anteriores consisten en un clúster físicamente instalado en el Centro Informático Científico de Andalucía (CICA) https://www.cica.es/

El clúster es utilizado por investigadores de las Universidades de Almería, Cádiz, Granada, Málaga y Sevilla.

La gestión del clúster se basa en la suite LadonOS 7.21, desarrollada sobre Centos 7.9, que incluye módulos para la gestión de recursos y cargas de trabajo, despliegue de nodos y de software centralizados, autenticación y autorización de usuarios, virtualización, seguridad y control de acceso.

SIE Ladon es un sistema conectado por Infiniband HDR, sobre un switch de 40 bocas a 200 Gb/s, que puede duplicar a 80 bocas a 100 Gb/s, para afrontar nuevas ampliaciones y un switch gigabit de DLINK para la conectividad IPMI 3.3 (estándar RedFish).

Todo el sistema queda monitorizado desde la herramienta GSM (Gigabyte Server Management) y la consola Check mk (basada en Nagios).

El sistema tiene una capacidad de cálculo de 1024 cores (2048 hilos de ejecución) de CPU sobre AMD Rome y más de 40.000 cores de NVIDIA de tecnología Ampere, que permite tener prestaciones de cálculo en GPU de casi 60 Tflops en doble precisión, 120 Tflops en simple precisión y de casi 2.000 TOPS (tera-operaciones/s), lo que permite afrontar cálculos clásicos de HPC, Deep Learning, Machine Learning e Inteligencia Artificial.

Las tarjetas instaladas permiten tener hasta 8 instancias virtualizadas a través del nuevo estándar MIG soportado por hardware, lo que aporta gran versatilidad.

Dispone de 224 TB de capacidad neta basada en BeeGFS (sistema de ficheros paralelo de alto rendimiento), lo que permite una gran concurrencia en el acceso a ficheros.

Sistemas Informáticos Europeos SIE, ha desplegado un amplio abanico de aplicaciones de cálculo científico, tanto comerciales (Ansys Mechanical, Fluent, Gurobi, MATLAB, Hugin) como software libre (FreeFem, gdal, nauty, ncview, paraview, fenics, entre otras).

Se han instalado también bibliotecas y herramientas de desarrollo para lenguajes Fortran, C++, Python, incluyendo los compiladores Gcc 10 y Nvidia HPC SDK (antes Portland).